Por Medea Benjamin y Nicolas JS Davies

Todos los artículos de Global Research se pueden leer en 51 idiomas activando el botón Traducir sitio web debajo del nombre del autor (solo disponible en la versión de escritorio).

Para recibir el boletín diario de Global Research (artículos seleccionados), haga clic aquí .

Haga clic en el botón Compartir de arriba para enviar por correo electrónico o reenviar este artículo a sus amigos y colegas. Síguenos en Instagram y Twitter y suscríbete a nuestro canal de Telegram . No dude en volver a publicar y compartir ampliamente los artículos de Global Research.

Campaña global de referencias de investigación: nuestros lectores son nuestro salvavidas

***

La revista israelí en línea +972 ha publicado un informe detallado sobre el uso por parte de Israel de un sistema de inteligencia artificial (IA) llamado “Lavender” para atacar a miles de hombres palestinos en su campaña de bombardeos en Gaza. Cuando Israel atacó Gaza después del 7 de octubre, el sistema Lavender tenía una base de datos de 37.000 hombres palestinos con presuntos vínculos con Hamás o la Jihad Islámica Palestina (JIP).

Lavender asigna una puntuación numérica, de uno a cien, a cada hombre en Gaza, basándose principalmente en datos de teléfonos móviles y redes sociales, y automáticamente añade a aquellos con puntuaciones altas a su lista de asesinatos de militantes sospechosos. Israel utiliza otro sistema automatizado, conocido como “¿Dónde está papá?”, para solicitar ataques aéreos para matar a estos hombres y sus familias en sus hogares.

Los cuerpos de los palestinos muertos en los ataques israelíes están enterrados en una fosa común en Khan Younis. Crédito de la foto: Al Jazeera.

El informe se basa en entrevistas con seis oficiales de inteligencia israelíes que han trabajado con estos sistemas. Como explicó uno de los oficiales a +972, al agregar un nombre de una lista generada por Lavender al sistema de seguimiento de la casa ¿Dónde está papá?, puede colocar la casa del hombre bajo vigilancia constante con drones y se lanzará un ataque aéreo una vez que regrese a casa.

Los oficiales dijeron que el asesinato “colateral” de las familias extensas de los hombres tuvo pocas consecuencias para Israel.

“Digamos que calculas [que hay un] [operativo] de Hamás más 10 [civiles en la casa]”, dijo el oficial. “Por lo general, estos 10 serán mujeres y niños. De manera tan absurda, resulta que la mayoría de las personas que mataste eran mujeres y niños”.

Los agentes explicaron que la decisión de atacar a miles de estos hombres en sus hogares es sólo una cuestión de conveniencia. Es simplemente más fácil esperar a que regresen a la dirección registrada en el sistema y luego bombardear esa casa o edificio de apartamentos, que buscarlos en el caos de la Franja de Gaza devastada por la guerra.

Los oficiales que hablaron con 972+ explicaron que en masacres israelíes anteriores en Gaza, no pudieron generar objetivos con la suficiente rapidez para satisfacer a sus jefes políticos y militares, por lo que estos sistemas de IA fueron diseñados para resolverles ese problema. La velocidad con la que Lavender puede generar nuevos objetivos sólo les da a sus cuidadores humanos un promedio de 20 segundos para revisar y sellar cada nombre, a pesar de que saben por las pruebas del sistema Lavender que al menos el 10% de los hombres elegidos para el asesinato y El familicidio tiene sólo una conexión insignificante o errónea con Hamás o la Yihad Islámica en Palestina.

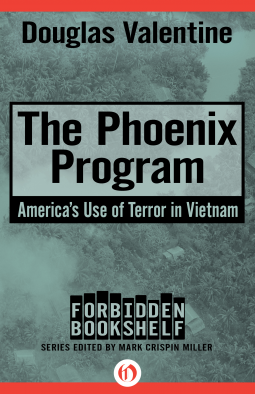

El sistema Lavender AI es una nueva arma desarrollada por Israel. Pero el tipo de listas de asesinatos que genera tienen una larga trayectoria en las guerras, ocupaciones y operaciones de cambio de régimen de la CIA en Estados Unidos. Desde el nacimiento de la CIA después de la Segunda Guerra Mundial, la tecnología utilizada para crear listas de asesinatos ha evolucionado desde los primeros golpes de estado de la CIA en Irán y Guatemala, hasta Indonesia y el programa Phoenix en Vietnam en los años 1960, América Latina en los años 1970 y década de 1980 y a las ocupaciones estadounidenses de Irak y Afganistán.

Imagen: Parche usado por los agentes del Programa Phoenix. (Crédito de la foto: Tuxxmeister / Wikimedia Commons CC BY-SA 3.0)

Así como el desarrollo de armas en Estados Unidos pretende estar a la vanguardia, o a la vanguardia, de la nueva tecnología, la CIA y la inteligencia militar estadounidense siempre han tratado de utilizar la última tecnología de procesamiento de datos para identificar y matar a sus enemigos.

La CIA aprendió algunos de estos métodos de oficiales de inteligencia alemanes capturados al final de la Segunda Guerra Mundial. Muchos de los nombres en las listas de asesinatos nazis fueron generados por una unidad de inteligencia llamada Fremde Heere Ost (Ejércitos Extranjeros del Este), bajo el mando del mayor general Reinhard Gehlen , el jefe de espías de Alemania en el frente oriental (ver David Talbot, The Devil's Chessboard , pág.268).

Gehlen y el FHO no tenían computadoras, pero sí tenían acceso a cuatro millones de prisioneros de guerra soviéticos de toda la URSS, y no tenían ningún escrúpulo en torturarlos para aprender los nombres de judíos y funcionarios comunistas en sus ciudades natales para compilar listas de asesinatos para la Gestapo y Einsatzgruppen.

Después de la guerra, al igual que los 1.600 científicos alemanes sacados de Alemania en la Operación Paperclip, Estados Unidos llevó a Gehlen y su personal superior a Fort Hunt en Virginia. Fueron recibidos por Allen Dulles , que pronto sería el primer y aún más antiguo director de la CIA. Dulles los envió de regreso a Pullach, en la Alemania ocupada, para reanudar sus operaciones antisoviéticas como agentes de la CIA. La Organización Gehlen formó el núcleo de lo que se convirtió en el BND, el nuevo servicio de inteligencia de Alemania Occidental, con Reinhard Gehlen como director hasta su jubilación en 1968.

Después de que un golpe de la CIA destituyó al popular primer ministro democráticamente elegido de Irán, Mohammad Mosaddegh, en 1953, un equipo de la CIA liderado por el mayor general estadounidense Norman Schwarzkopf capacitó a un nuevo servicio de inteligencia, conocido como SAVAK , en el uso de listas de asesinatos y tortura. SAVAK utilizó estas habilidades para purgar al gobierno y al ejército de Irán de presuntos comunistas y más tarde para perseguir a cualquiera que se atreviera a oponerse al Sha.

En 1975, Amnistía Internacional estimó que Irán tenía entre 25.000 y 100.000 prisioneros políticos y tenía “la tasa más alta de penas de muerte en el mundo, ningún sistema válido de tribunales civiles y una historia de tortura increíble”.

En Guatemala, un golpe de la CIA en 1954 reemplazó al gobierno democrático de Jacobo Arbenz Guzmán por una dictadura brutal. A medida que la resistencia crecía en la década de 1960, las fuerzas especiales estadounidenses se unieron al ejército guatemalteco en una campaña de tierra arrasada en Zacapa, que mató a 15.000 personas para derrotar a unos cientos de rebeldes armados. Mientras tanto, escuadrones de la muerte urbanos entrenados por la CIA secuestraron, torturaron y mataron a miembros del PGT (Partido del Trabajo Guatemalteco) en la Ciudad de Guatemala, en particular a 28 destacados líderes sindicales que fueron secuestrados y desaparecidos en marzo de 1966.

Una vez reprimida esta primera ola de resistencia, la CIA creó un nuevo centro de telecomunicaciones y una agencia de inteligencia, con sede en el palacio presidencial. Compiló una base de datos de “subversivos” en todo el país que incluía líderes de cooperativas agrícolas y activistas laborales, estudiantiles e indígenas, para proporcionar listas cada vez mayores para los escuadrones de la muerte. La guerra civil resultante se convirtió en un genocidio contra los pueblos indígenas de Ixil y las tierras altas occidentales que mató o desapareció al menos a 200.000 personas.

Este patrón se repitió en todo el mundo, dondequiera que los líderes populares y progresistas ofrecieran esperanza a su pueblo de maneras que desafiaban los intereses estadounidenses. Como escribió el historiador Gabriel Kolko en 1988,

“La ironía de la política estadounidense en el Tercer Mundo es que, si bien siempre ha justificado sus objetivos y esfuerzos más amplios en nombre del anticomunismo, sus propios objetivos le han hecho incapaz de tolerar cambios de cualquier sector que afecten significativamente a sus propios intereses. "

Cuando el general Suharto tomó el poder en Indonesia en 1965, la embajada de Estados Unidos compiló una lista de 5.000 comunistas para que sus escuadrones de la muerte los persiguieran y mataran. La CIA estimó que finalmente mataron a 250.000 personas, mientras que otras estimaciones llegan al millón.

Veinticinco años después, la periodista Kathy Kadane investigó el papel de Estados Unidos en la masacre de Indonesia y habló con Robert Martens, el funcionario político que dirigió el equipo de la CIA y el Estado que compiló la lista de asesinatos.

"Realmente fue de gran ayuda para el ejército", dijo Martens a Kadane. “Probablemente mataron a mucha gente y probablemente tengo mucha sangre en mis manos. Pero eso no es del todo malo: hay un momento en el que hay que atacar con fuerza en un momento decisivo”.

Kathy Kadane también habló con el ex director de la CIA William Colby , quien fue jefe de la división del Lejano Oriente de la CIA en los años 1960. Colby comparó el papel de Estados Unidos en Indonesia con el Programa Phoenix en Vietnam, que se lanzó dos años después, afirmando que ambos fueron programas exitosos para identificar y eliminar la estructura organizativa de los enemigos comunistas de Estados Unidos.

El programa Phoenix fue diseñado para descubrir y desmantelar el gobierno en la sombra del Frente de Liberación Nacional (FLN) en todo Vietnam del Sur. El Centro de Inteligencia Combinada de Phoenix en Saigón introdujo miles de nombres en una computadora IBM 1401, junto con sus ubicaciones y sus supuestos roles en el NLF. La CIA atribuyó al programa Phoenix la muerte de 26.369 funcionarios del FLN, mientras que otros 55.000 fueron encarcelados o persuadidos a desertar. Seymour Hersh revisó documentos del gobierno de Vietnam del Sur que cifraban la cifra de muertos en 41.000 .

Puede ser imposible saber cuántos de los muertos fueron identificados correctamente como funcionarios del NLF, pero los estadounidenses que participaron en las operaciones de Phoenix informaron haber matado a personas equivocadas en muchos casos. El Navy SEAL Elton Manzione contó al autor Douglas Valentine ( The Phoenix Program ) cómo mató a dos niñas en un ataque nocturno a una aldea y luego se sentó sobre una pila de cajas de municiones con una granada de mano y un M-16, amenazando con volar. hasta que consiguió un billete de vuelta a casa.

"Todo el aura de la Guerra de Vietnam estuvo influenciada por lo que sucedió en los equipos" cazadores-asesinos "de Phoenix, Delta, etc.", le dijo Manzione a Valentine. “Ese fue el punto en el que muchos de nosotros nos dimos cuenta de que ya no éramos los buenos con sombreros blancos que defendían la libertad, que éramos asesinos, pura y simplemente. Esa desilusión se extendió a todos los demás aspectos de la guerra y, finalmente, fue responsable de que se convirtiera en la guerra más impopular de Estados Unidos”.

Incluso cuando la derrota de Estados Unidos en Vietnam y la “fatiga de guerra” en Estados Unidos condujeron a una próxima década más pacífica, la CIA continuó diseñando y apoyando golpes de estado en todo el mundo, y proporcionando a los gobiernos posteriores al golpe listas de asesinatos cada vez más informatizadas para consolidar su dominio.

Después de apoyar el golpe del general Pinochet en Chile en 1973, la CIA jugó un papel central en la Operación Cóndor, una alianza entre gobiernos militares de derecha en Argentina, Brasil, Chile, Uruguay, Paraguay y Bolivia, para cazar a decenas de miles de sus y a sus oponentes políticos y disidentes, matando y desapareciendo al menos a 60.000 personas.

El papel de la CIA en la Operación Cóndor todavía está envuelto en secreto, pero Patrice McSherry, politólogo de la Universidad de Long Island, investigó el papel de Estados Unidos y concluyó :

“La Operación Cóndor también contó con el apoyo encubierto del gobierno estadounidense. Washington proporcionó a Cóndor inteligencia y entrenamiento militar, asistencia financiera, computadoras avanzadas, tecnología de seguimiento sofisticada y acceso al sistema de telecomunicaciones continental ubicado en la Zona del Canal de Panamá”.

La investigación de McSherry reveló cómo la CIA apoyó a los servicios de inteligencia de los estados Cóndor con enlaces computarizados, un sistema de télex y máquinas de codificación y decodificación especialmente diseñadas por el Departamento de Logística de la CIA. Como escribió en su libro Estados depredadores: Operación Cóndor y guerra encubierta en América Latina :

“El sistema de comunicaciones seguras del sistema Cóndor, Condortel,… permitió que los centros de operaciones de Cóndor en los países miembros se comunicaran entre sí y con la estación matriz en una instalación estadounidense en la Zona del Canal de Panamá. Este vínculo con el complejo de inteligencia militar de Estados Unidos en Panamá es una prueba clave sobre el patrocinio secreto de Estados Unidos a Condor…”

La Operación Cóndor finalmente fracasó, pero Estados Unidos brindó apoyo y entrenamiento similar a gobiernos de derecha en Colombia y Centroamérica a lo largo de la década de 1980 en lo que altos oficiales militares han llamado un “enfoque silencioso, disfrazado y libre de medios” para la represión y las listas de asesinatos.

La Escuela de las Américas (SOA) de Estados Unidos capacitó a miles de oficiales latinoamericanos en el uso de la tortura y los escuadrones de la muerte, como lo describió el mayor Joseph Blair, ex jefe de instrucción de la SOA, a John Pilger en su película La guerra que no ves. :

“La doctrina que se enseñó fue que, si quieres información, utilizas el abuso físico, el encarcelamiento ilegal, las amenazas a familiares y el asesinato. Si no puedes obtener la información que deseas, si no puedes lograr que la persona se calle o deje de hacer lo que está haciendo, la asesinas... y la asesinas con uno de tus escuadrones de la muerte”.

Cuando se transfirieron los mismos métodos a la ocupación militar hostil de Estados Unidos en Irak después de 2003, Newsweek lo tituló “La opción Salvador”. Un oficial estadounidense explicó a Newsweek que los escuadrones de la muerte estadounidenses e iraquíes estaban atacando a civiles iraquíes así como a combatientes de la resistencia.

"La población sunita no está pagando ningún precio por el apoyo que brinda a los terroristas", afirmó. “Desde su punto de vista, es gratuito. Tenemos que cambiar esa ecuación”.

Estados Unidos envió a Irak a dos veteranos de sus guerras sucias en América Latina para que desempeñaran papeles clave en esa campaña. El coronel James Steele dirigió el Grupo Asesor Militar de Estados Unidos en El Salvador de 1984 a 1986, entrenando y supervisando a las fuerzas salvadoreñas que mataron a decenas de miles de civiles. También estuvo profundamente involucrado en el escándalo Irán-Contra, escapando por poco de una sentencia de prisión por su papel en la supervisión de envíos desde la base aérea de Ilopango en El Salvador a los Contras respaldados por Estados Unidos en Honduras y Nicaragua.

En Irak, Steele supervisó el entrenamiento de los comandos especiales de la policía del Ministerio del Interior, rebautizados como Policía “Nacional” y luego “Federal” después del descubrimiento de su centro de tortura en Al-Jadiriyah y otras atrocidades.

Bayan al-Jabr, comandante de la milicia de la Brigada Badr entrenada en Irán, fue nombrado Ministro del Interior en 2005, y los milicianos de Badr fueron integrados en el escuadrón de la muerte de la Brigada Wolf y otras unidades de la Policía Especial. El principal asesor de Jabr era Steven Casteel , ex jefe de inteligencia de la Agencia Antidrogas de Estados Unidos (DEA) en América Latina.

Los escuadrones de la muerte del Ministerio del Interior libraron una guerra sucia en Bagdad y otras ciudades, llenando la morgue de Bagdad con hasta 1.800 cadáveres por mes, mientras Casteel alimentaba a los medios occidentales con historias absurdas, como que todos los escuadrones de la muerte eran “insurgentes” en casas robadas. uniformes policiales.

Mientras tanto, las fuerzas de operaciones especiales estadounidenses llevaron a cabo incursiones nocturnas de “matar o capturar” en busca de líderes de la Resistencia. El general Stanley McChrystal, comandante del Comando Conjunto de Operaciones Especiales de 2003 a 2008, supervisó el desarrollo de un sistema de base de datos, utilizado en Irak y Afganistán, que compilaba números de teléfonos celulares extraídos de teléfonos celulares capturados para generar una lista de objetivos en constante expansión para incursiones nocturnas y ataques aéreos.

La selección de teléfonos móviles en lugar de personas reales permitió la automatización del sistema de selección de objetivos y excluyó explícitamente el uso de inteligencia humana para confirmar identidades. Dos altos comandantes estadounidenses dijeron al Washington Post que sólo la mitad de las redadas nocturnas atacaron la casa o persona adecuada.

En Afganistán, el presidente Obama puso a McChrystal a cargo de las fuerzas estadounidenses y de la OTAN en 2009, y su “análisis de redes sociales” basado en teléfonos móviles permitió un aumento exponencial de las redadas nocturnas, de 20 redadas por mes en mayo de 2009 a hasta 40 por noche en 2009. Abril de 2011.

Al igual que con el sistema Lavender en Gaza, este enorme aumento de objetivos se logró tomando un sistema diseñado originalmente para identificar y rastrear a un pequeño número de altos comandantes enemigos y aplicándolo a cualquier persona sospechosa de tener vínculos con los talibanes, basándose en los datos de sus teléfonos móviles. .

Esto llevó a la captura de una avalancha interminable de civiles inocentes, por lo que la mayoría de los civiles detenidos tuvieron que ser liberados rápidamente para dejar espacio a otros nuevos. El aumento de las matanzas de civiles inocentes en incursiones nocturnas y ataques aéreos alimentó la ya feroz resistencia a la ocupación de Estados Unidos y la OTAN y, en última instancia, condujo a su derrota.

La campaña con aviones no tripulados del presidente Obama para matar a presuntos enemigos en Pakistán, Yemen y Somalia fue igualmente indiscriminada, con informes que sugieren que el 90% de las personas que mató en Pakistán eran civiles inocentes.

Y, sin embargo, Obama y su equipo de seguridad nacional seguían reuniéndose en la Casa Blanca cada “martes del terror” para seleccionar a quién atacarían los drones esa semana, utilizando una “matriz de disposición” computarizada orwelliana para proporcionar cobertura tecnológica a sus decisiones de vida o muerte.

Al observar esta evolución de sistemas cada vez más automatizados para matar y capturar enemigos, podemos ver cómo, a medida que la tecnología de la información utilizada ha avanzado desde el télex a los teléfonos móviles y desde las primeras computadoras IBM a la inteligencia artificial, la inteligencia y la sensibilidad humanas que podían detectar errores , priorizar la vida humana e impedir la matanza de civiles inocentes ha sido progresivamente marginada y excluida, lo que hace que estas operaciones sean más brutales y horripilantes que nunca.

Nicolás tiene al menos dos buenos amigos que sobrevivieron a las guerras sucias en América Latina porque alguien que trabajaba en la policía o el ejército les informó que sus nombres estaban en una lista de muerte, uno en Argentina y el otro en Guatemala. Si sus destinos hubieran sido decididos por una máquina de inteligencia artificial como Lavender, ambos estarían muertos hace mucho tiempo.

Al igual que con los supuestos avances en otros tipos de tecnología armamentista, como drones y bombas y misiles de “precisión”, las innovaciones que pretenden hacer que los objetivos sean más precisos y eliminar el error humano han conducido al asesinato en masa automatizado de personas inocentes, especialmente mujeres y niños. cerrándonos el círculo de un holocausto al siguiente.

*

Nota para los lectores: haga clic en el botón compartir de arriba. Síguenos en Instagram y Twitter y suscríbete a nuestro canal de Telegram. No dude en volver a publicar y compartir ampliamente los artículos de Global Research.

Medea Benjamin es cofundadora de CODEPINK for Peace y autora de varios libros, entre ellos Inside Iran: The Real History and Politics of the Islamic Republic of Iran .

Nicolas JS Davies es periodista independiente, investigador de CODEPINK y autor de Blood on Our Hands: The American Invasion and Destruction of Iraq .

Medea Benjamin y Nicolas JS Davies son los autores de War in Ukraine: Making Sense of a Senseless Conflict , publicado por OR Books en noviembre de 2022. Son colaboradores habituales de Global Research.

La imagen destacada es de Shutterstock.

Comente artículos de investigación global en nuestra página de Facebook